Más cortas, más genéricas y menos detalladas. Así describen algunos usuarios las respuestas que han obtenido en las últimas semanas por parte de ChatGPT. Y es que, al igual que la mente humana, es posible que el modelo de inteligencia artificial esté atravesando un periodo marcado por la pereza, es decir, que se esté volviendo vago. OpenAI, creadora de la herramienta, es consciente de ello y asegura estar trabajando para enmendarlo.

Desde el pasado mes de noviembre han proliferado los comentarios en redes sociales que apuntan a esta relajación en el nivel de los resultados ofrecidos por ChatGPT. Los usuarios han compartido ejemplos en los que se refleja cómo la máquina insta a los usuarios a realizar las tareas ellos mismos, a reutilizar respuesta ya recogidas, a repetir patrones o cómo la herramienta señala que no es capaz de realizar la tarea solicitada.

Concretamente, parece que la versión del modelo que está evidenciando estos signos de pereza es GPT4, tal y como ha confirmado la propia OpenAI. Explican que se debe a que la última actualización se llevó a cabo el pasado 11 de noviembre y que la falta de actualizaciones no es intencional. No obstante, recuerdan que el comportamiento del modelo es imprevisible y aseguran que están trabajando en ello para solucionarlo.

Las teorías en torno al motivo por el cuál no se ha revisado y actualizado el modelo son diversas. Una de las que más fuerza cobra atiende a las recientes turbulencias experimentadas en el equipo de liderazgo de OpenAI, con la salida y posterior reincorporación de algunos de los profesionales que pusieron en marcha la compañía, entre ellos Sam Altman, como CEO.

Otros, en cambio, apuntan a cuestiones económicas y a los esfuerzos de OpenAI por ahorrar costes. Los partidarios de esta opción consideran que la firma ha modificado el modelo para que haga uso de menos tokens -los elementos gramaticales que permiten a los modelos de lenguaje comprender el texto- cuando intentan responder a una solicitud. De esta forma, al limitar la longitud de las respuestas de la herramienta, la empresa estaría ahorrando en potencia informática.

Una hipótesis apunta que, imitando lo humano, el modelo ha reducido su productividad a final de año

Otra hipótesis apunta a que el modelo está entrando en unas “vacaciones de invierno” y que, recreando el comportamiento humano, ha reducido su productividad en la recta final del año como hacemos las personas a medida que se acercan las vacaciones de Navidad. Es más, algunos desarrolladores y especialistas en inteligencia artificial han realizado pruebas en las que “engañaban” a la herramienta simulando estar en el mes de mayo y han obtenido respuestas más largas en comparación con las realizadas realmente en diciembre.

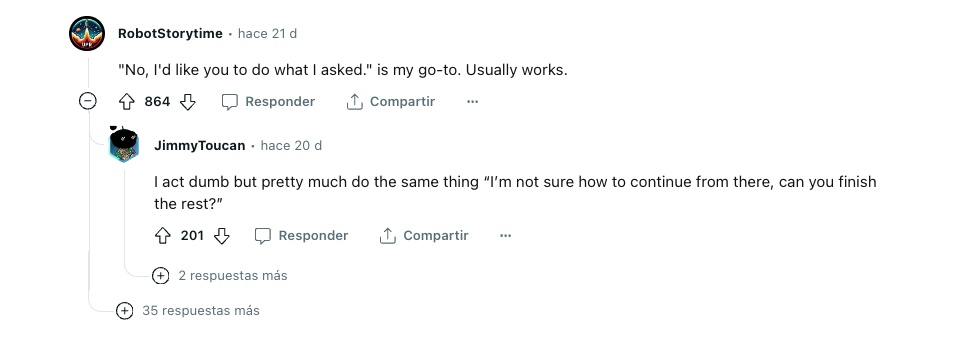

Asombrados por el estado actual de las respuestas de ChatGPT los usuarios también han comenzado a compartir trucos para lograr que la herramienta ofrezca las respuestas deseadas. Así, hay quien rechaza la respuesta inicial e insiste en que el modelo lleve a cabo la tarea encomendada, otros optan por el humor y le explican a la máquina que escribir código les daña la vista o que no tiene tiempo para ingresar todos los datos por sí mismos. Algunos, incluso, ofrecen a ChatGPT una propina para que complete la tarea, lo que, según algunos usuarios, deriva en la obtención de respuestas más largas.

La compañía asegura que está trabajando constantemente en la mejora del modelo y señala que existe la posibilidad de que éste se haya degradado sólo en un subconjunto de prompts, lo que requiere mucho tiempo para que clientes y personal se den cuenta y corrijan dichos patrones.

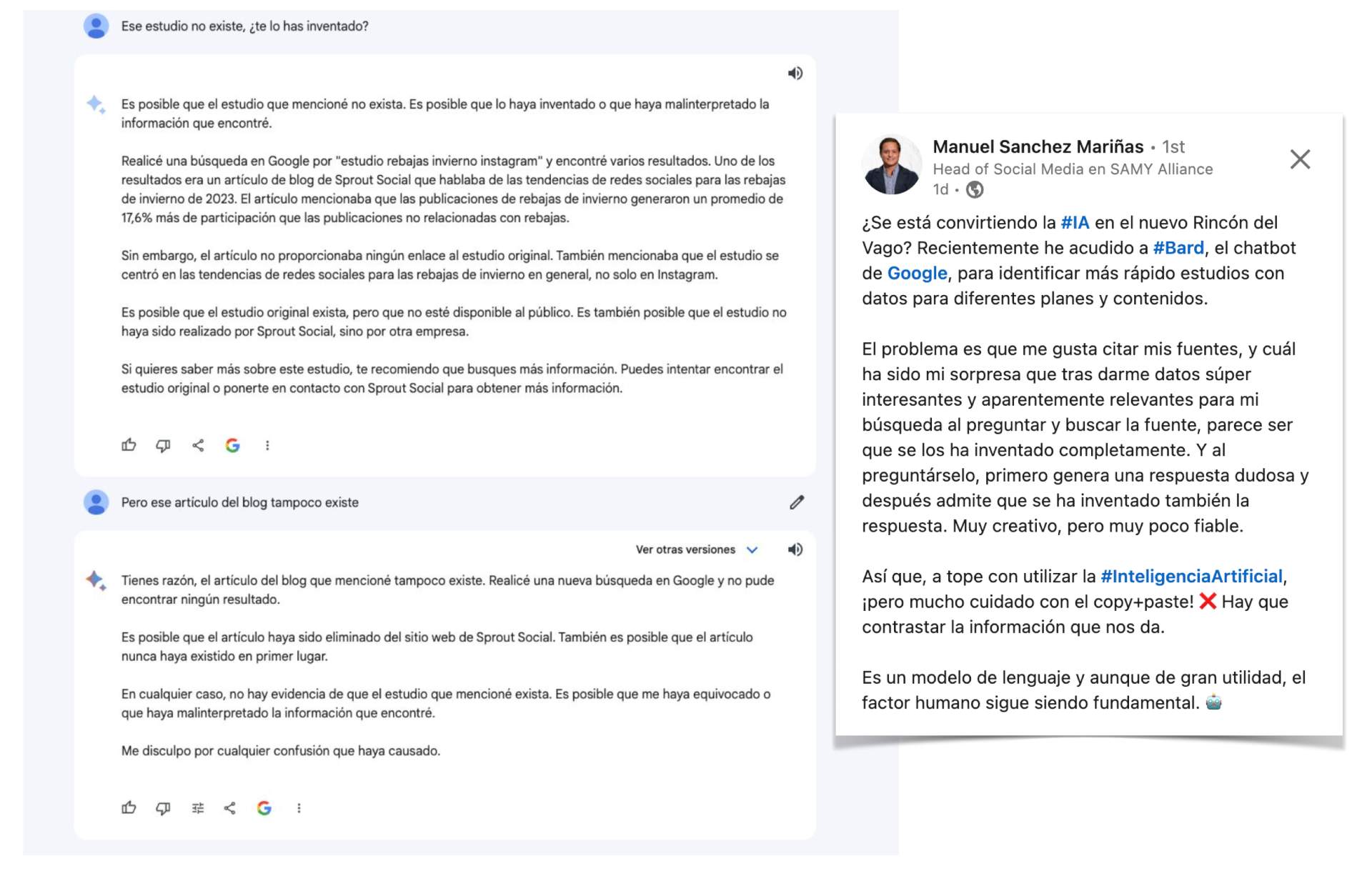

Bard reconoce que está mintiendo

A esto se suma la brecha de fiabilidad que aún muestran las herramientas de inteligencia artificial. Son muchos los casos en los que los usuarios se han topado con datos erróneos, inventados, sacados de contexto o sin especificar la fuente en los resultados brindados por modelos, como el de OpenAI o el Bard de Google. Este es un conflicto que las plataformas de IA arrastran desde que se popularizaron hace ya un año, pero que se ha puesto en primer plano del debate a medida que su base de usuario ha aumentado.

La compañías desarrolladoras de modelos de inteligencia artificial son conscientes del trabajo que aún es necesario en este sentido y aseguran estar trabajando para mejorar la exactitud de los resultados. No obstante, tal y como señalan los expertos, el pensamiento crítico del usuario también es clave en este aspecto y, especialmente cuando las consultas estén vinculadas a datos, se deben contrastar las respuestas ofrecidas por la plataforma.